- インターネット上にはAIが作成したコンテンツがあふれ始めており、このことがAIモデルの今後に厄介な問題をもたらす可能性が指摘されています。

- チャットGPTのような言語モデルはオンライン上のコンテンツを利用して学習しているため、AIが合成コンテンツを生成するにしたがって、「モデル崩壊」と呼ばれるコンピューター工学上の問題が起こる可能性が生じています。

- 学習モデルから合成データをフィルタリングすることが、主要な研究領域になりつつあり、AI生成コンテンツがインターネット上を埋め尽くす中で、この重要性は高まるとみられています。

AI生成コンテンツが

AI学習において問題に

「ウロボロス」というのはアステカや古代中国、ネイティブ・アメリカンなどの文化にも見受けられる古代のシンボル。自らの尻尾を噛んで環状になった蛇、または竜を図案化したものです。これは“始め”と終わりがないことから、自己の消尽と更新を繰り返す永劫回帰や無限、真理と知識の合体、創造など幅広い意味を持っていますが…。

そんな古代の象徴は現代にも通じるようです。AI(人工知能)が話題となっているこの時代に、「ウロボロス」という象徴が全く新しい痛烈な意味で注目されています。それは負の領域で…。

「チャットGPTのようなAI言語モデルによって作成された編集コンテンツがインターネットを埋め尽くし始めると(これだけでもウェブコンテンツ編集者にとっては憂慮すべき事態ですが…)、次から次にエラーが出現する」というのです。

これは大問題と言えるでしょう。その理由は、こうした言語モデルはインターネット上で収集した膨大なデータを基に学習しているからです。つまり、ネット上で増え続けるAI生成データを再帰的に学習するAIは、自らの尻尾を食べる「ウロボロス」状態にあるということです。より具体的な表現をするなら、「最悪の伝言ゲーム」といったところでしょうか。

AIはエラーのある合成データ(現実のデータセットから人工的に生成または模倣されたデータ)で学習し始める可能性は否めません。むしろ、すでに生成AIを使用した経験のある人なら直観的に理解できるかと思います。その結果、エラーという残留毒素がどんどん蓄積していき、「AIが全く意味をなさないデータを出力する」という事態になりかねないのです。AI研究者はこの現象を、「model collapse(AIモデル崩壊)」と呼んでいます。AIによる気づかないような些細な嘘が生成を重ねるごとに積み重なって、あるとき、取り換えしのつかない嘘になる…ということです。

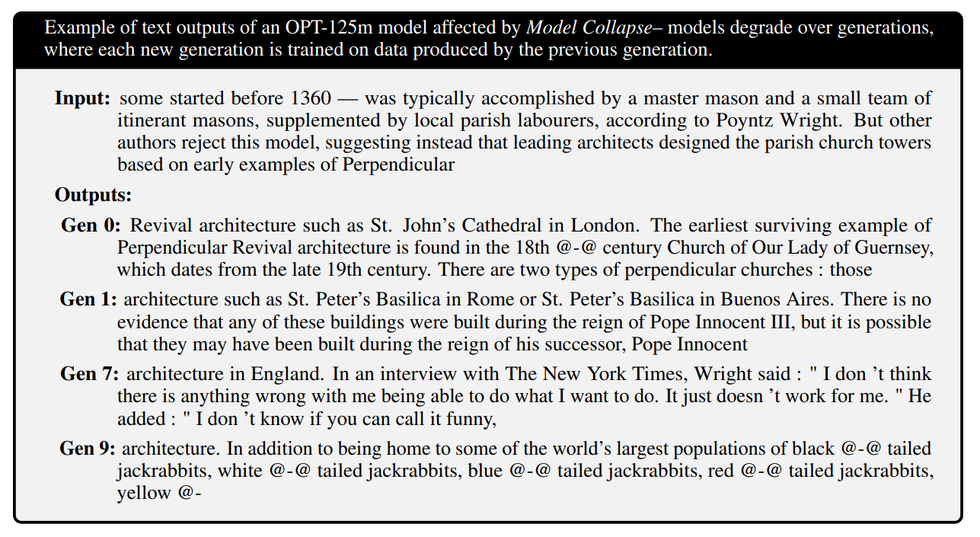

オープンアクセスのプレプリント(査読前論文)サイト「arXiv」では先頃、米メタ社の大規模言語モデル「OPT-125m」を使って、英国の建築に関するテキストを作成させる研究の結果が掲載されました。

この研究では、人間が作成したテキストをAIの言語モデルに読み込ませ、その出力コンテンツを「第0世代」とし、この第0世代が出力したコンテンツで学習したAIモデルを「第1世代」、第1世代が出力したコンテンツで学習したモデルを「第2世代」というように次々と合成データを生成してAIを訓練しました。

その結果、同様の作業を10回繰り返した「第9世代」のAIモデルが返した答えは、回答スピードだけは速くなりましたが、完全に意味をなしてはいなかったそうです。

またarXivには最近、他のAIアートで学習させたAI画像ジェネレーターについての研究論文も掲載されました。「AI生成データのみで学習したAIに鳥や花の画像を生成させようとしたところ、3世代目にはもうぼやけて認識できない画像が出力された」というのです。

この2つの例だけで言えば、危険性は比較的低いと言えるかもしれません。が、このように再帰的なデータ学習を繰り返すことで、人種やジェンダーの偏見などを助長する恐れもあります…。

既に次のような例にも表れています――それは、「チャットGPTが“テロリスト”を人種的なプロファイリングで解答した」というもので、2022年12月4日にカリフォルニア大学バークレー校Computation and Language Labのスティーブン・ピアンタドシ氏によってX(ツイッター)で共有されました。

そのため新しいAIモデルを効果的に学習させるためには、汚染されていないデータが必要だということになります。米国立科学財団(NSF)が設立したThe Institute for Foundations of Machine Learningの共同ディレクターであるアレックス・ディマキス氏は、米月刊誌『アトランティック』に対し「現在フィルタリングが、重要な研究領域となっています。そのフィルタリングいかんで、そのモデルのクオリティに大きな影響を与えることがわかっているので…」と語っています。

そんなディマキス氏は、「少量でも高品質なデータを集めれば、大規模に行われた合成データを上回ることもできます」とも述べます。もちろん、人間が有するデータにも欠点がないわけではなく、さまざまなところにバイアスが存在するものです。が、ここのAIを用いることで、これらのデータセットからバイアスを取り除き、より良いデータセットを作成することもできる可能性あるはずです。

今のところエンジニアは、データ素材それぞれをフィルタリングしなければなりません。そのデータは、AIによって合成されたデータではないことを確認するためです。つまり現在、世の中では「人間がAIに取って代わられるのではないか⁉」ということが懸念されていますが、「世界を変えるような言語モデルには、まだまだ人間の手が必要だ」というなのです。

Translation / Keiko Tanaka

Edit / Satomi Tanioka

※この翻訳は抄訳です